Learning to reject. Quando l’IA diventa saggia

Se non esiste un algoritmo che trovi soluzione a tutti i fortunali della vita, peggio sta messo l’indolente Adamo che all’indice teso del Signore giustappone la mano intorpidita: spesso non sa cos’è meglio per sé, o non ha la forza metterlo in pratica. Sperimentalmente, infatti, è noto che il “sistema 2” – il fittizio deuteragonista della mente a cui lo psicologo Daniel Kahneman, nel saggio Pensieri lenti e veloci del 2011, attribuisce capacità di calcolo formale e statistico – è talmente pigro da lasciare il passo al “sistema 1”, sempre all’erta e rapido nel mettere in ordine i fatti ma pieno di pregiudizi, pur consapevole (ammesso e non concesso) che il “sistema 1” potrebbe fare una mossa contro l’interesse dell’agente. Un tipico bias o pregiudizio cognitivo, ad esempio, è il WYSIATI, What You See Is All There Is. Molti imprenditori, inclini a un’illusione di controllo, falliscono per essersi concentrati troppo sulla propria abilità tralasciando il ruolo delle competenze altrui e della fortuna. Soluzione? Da una parte, l’esistenza conclamata di pregiudizi algoritmici – gli afroamericani ne sanno qualcosa – indica che affidarsi ad un “sistema 2” artificiale è poco utile e molto pericoloso. Dall’altra, di converso, controllare dall’esterno un sistema artificiale identificato col fulmineo “sistema 1” è per un utente umano – anzi, per il suo cervello – un problema intrattabile.

Ma l’Intelligenza Artificiale, come Socrate, sa di non sapere. Il learning to reject, una nuova tecnica di sospensione del giudizio incerto e rigetto del risultato sospetto, l’ha resa saggia. Immaginiamo un programmatore dal piglio severo, che sa che la sua macchina – magari una rete neurale in allenamento per classificare immagini di frutta per l’industria agroalimentare – produce mediamente risultati con accuratezza del 90%, cioè ogni cento casi commette in media dieci errori. Sapendo la giovane educanda un po’ immatura, per stuzzicarla le domanda: tu che produci questa accuratezza sui dati che ti vengono proposti, quanto invece sei sicura di te stessa? Quanta fiducia hai in te? Notoriamente, infatti, è meglio non credersi più competenti di quel che si è. La macchina risponde fornendo una misura di confidence. Per esempio, ha detto che quanto esaminato è l’immagine di una mela, dove “mela” è l’etichetta-target dell’apprendimento, e sostiene di essere sicura di sé, nell’affermarlo, al 95%. Ma il maestro, che conosce la spavalderia dell’alunna, coglie un sorrisetto di troppo. Preso dal dubbio, domanda ancora: sei proprio sicura di avermi appena detto la verità? Redarguita, la rete neurale fa un passo indietro. A dire il vero no, risponde ancora: è stata over-confident e ha peccato, perché in medio stat virtus. Il secondo step è dunque la calibrazione della funzione di confidenza: mai più dovrà succedere che la probabilità che l’output sia giusto, data una certa confidence del computer, risulti più bassa (sfacciataggine) o più alta (eccesso di modestia) della stessa sicurezza di sé.

Tuttavia, che senso avrebbe imparare a darsi un voto per poi continuare ad agire come se nulla fosse? Un po’ di contegno, insomma. Moderazione. A questo scopo, l’ultimo step è l’inserimento nel sistema di un discriminatore che rigetta le predizioni per cui la confidence è stata inferiore ad una certa soglia. All’occorrenza, quindi, fermerà tutto e chiederà aiuto, più o meno esplicitamente chiamando in causa l’utente. Stavolta, dovendosi soffermare su pochi casi, egli avrà le competenze per pronunciarsi, correggendo l’apprendimento del modello o ponderando autonomamente la decisione da prendere. Un’educazione riuscita, dunque: completa e morigerata. Non manca nemmeno l’epochè, la sospensione del giudizio. Se l’occhio deve l’acutezza alla corteccia cerebrale, o la mano è prensile grazie a un intricato sistema di ossa e tendini, per diventare virtuosi invece – scriveva Aristotele nell’Etica Nicomachea (1103a) – «quello che si deve fare quando si è appreso, facendolo, lo impariamo.» Se siamo coinvolti fino a tal punto, qualcosa lascia intendere che d’ora in poi gli appunti del lungo viaggio digitale li scriveremo insieme.

Credits Copertina: Freepik.com

Leggi anche

Mani che pensano, le iniziative dei musei di Leonardo per la Settimana della Cultura d’Impresa

La XXIII Settimana della Cultura d’Impresa, dal 14 al 28 novembre, esplora il tema “Mani che pensano: Intelligenza Artificiale, arte e cultura per il rilancio dell’impresa” con eventi dedicati all’innovazione e al patrimonio industriale italiano

Marconi, vedere l'invisibile. La mostra evento sul primo innovatore globale

Al via "Guglielmo Marconi. Vedere l’invisibile" la mostra ospitata dal VIVE - Vittoriano e Palazzo Venezia di Roma dedicata all'inventore in occasione dei 150 anni dalla nascita. Fondazione Leonardo partecipa con il documentario "Elettra, la nave laboratorio"

Uomo e intelligenza artificiale: siamo ancora noi i protagonisti? Le riflessioni sul futuro di Luca Josi

Cosa dovrà fare il lavoratore per resistere alla supremazia delle macchine? Adattarsi o distinguersi attraverso le materie umanistiche?

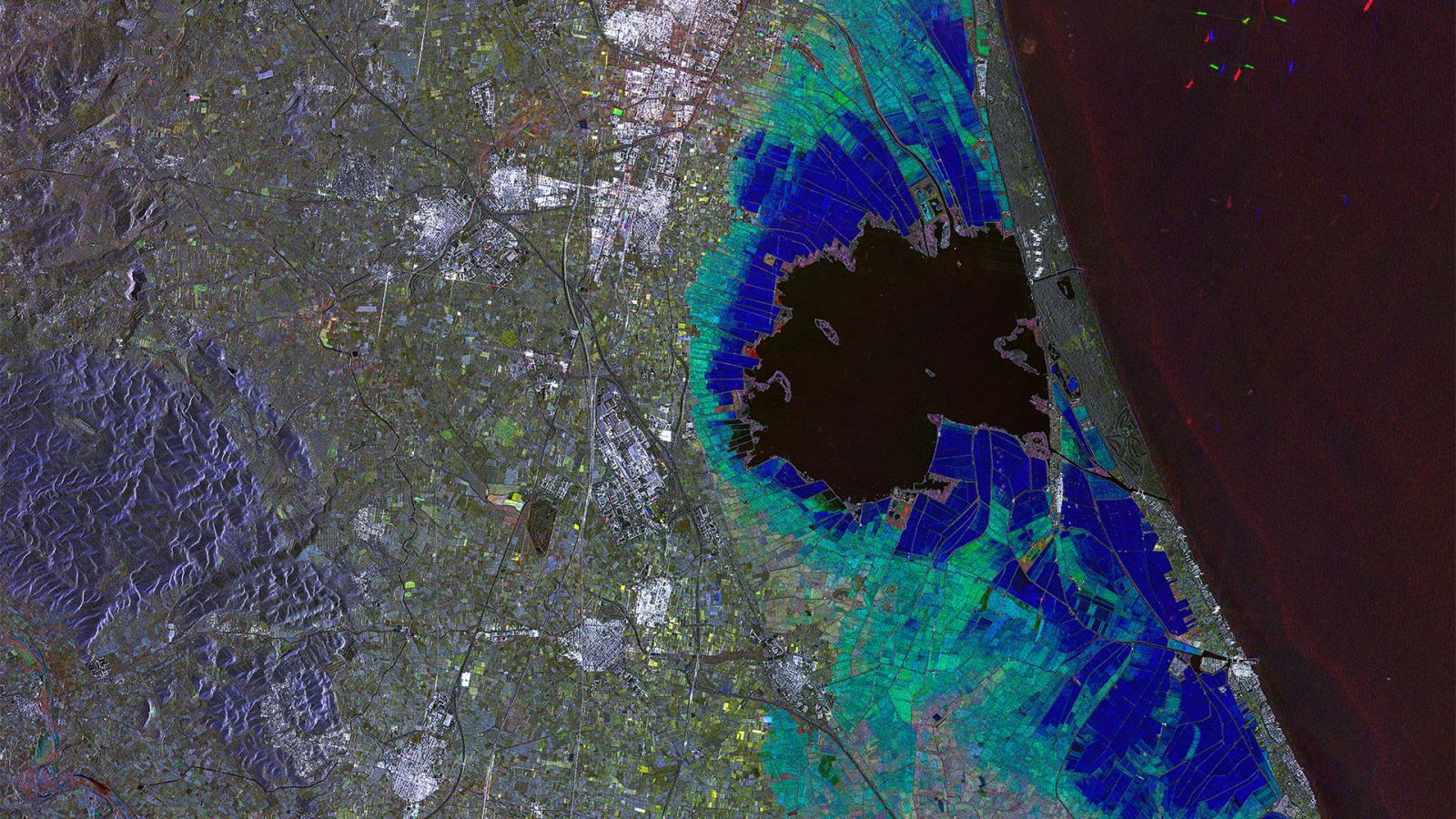

Alluvione a Valencia, le immagini satellitari del disastro: prima e dopo

Il Servizio di Gestione delle Emergenze Copernicus Rapid Mapping ha avviato operazioni di mappatura per valutare l'impatto della devastante alluvione causata dal fenomeno meteorologico DANA