Il rasoio smussato e la macchina dal naso storto

Supponiamo di stare osservando dall’esterno e con piena visuale un edificio grigio e anonimo, senza alcuna finestra, dotato unicamente di una porta di ingresso e di una seconda porta, sul retro, di uscita. Sono le ore 18, ed una donna imbellettata, dai biondi capelli cotonati ed elegantemente vestita, entra nell’edificio, uscendone alle ore 20 in punto coi capelli in disordine, gli abiti sgualciti, il copricapo storto ed il trucco un po’ sciolto. Che sarà mai successo? Difficile stabilirlo: potrebbe esserle capitato di tutto. Potrebbe essersi trattato di un vivace incontro amoroso. O forse che la signora si sia imbattuta nel marito animalesco? O magari nulla di tutto ciò: si è svestita per sbrigare faccende casalinghe e si è rivestita frettolosamente perché in ritardo per un appuntamento. O ancora, potrebbe darsi che stia vivendo un periodo difficile e si sia lasciata andare ad una disperata crisi di pianto. Strano ma vero, in intelligenza artificiale e più precisamente in eXplainable AI – il settore di ricerca volto a chiarire come e perché a certi ingressi di un sistema intelligente corrispondano esattamente certe uscite – questa situazione pirandelliana senza via di uscita prende il nome di instabilità, ovvero la molteplicità di buoni modelli esplicativi.

Per illustrare il fatto, prendiamo due dispositivi: il primo, dal funzionamento non trasparente e dunque incomprensibile, è un classificatore di immagini; il secondo funge da osservatore esterno del comportamento del primo e cerca di carpirne il segreto. Per due istanze x e x’ (detto “x primo”) assai simili tra di loro, come due fotografie del medesimo cagnolino correttamente riconosciute dal dispositivo opaco quali “razza setter”, può ben capitare che l’algoritmo osservatore ricavi due spiegazioni post-hoc piuttosto diverse tra loro – l’una soffermandosi sulla forma delle orecchie, l’altra sul muso come fattori che hanno pesato nel riconoscimento – minando l’affidabilità dell’intero sistema. Infatti, è il classificatore ad aver effettivamente prodotto comportamenti anomali o l’osservatore a non sapere a quali prove aggrapparsi? Quest’ambiguità maliziosa, non specificamente riferita alle macchine, fu lucidamente colta dallo statistico americano Leo Breiman dell’Università di Berkeley (California) in un breve saggio del 2001 per la rivista Statistical Science, intitolato Statistical Modeling: The Two Cultures. I dati di un fenomeno nel mondo, scriveva, sono prodotti di una scatola nera chiamata natura e si possono analizzare secondo due approcci: una data modeling culture assume che i processi naturali siano stocastici e rintracciabili tramite regressione matematica; una algorithmic modeling culture, invece, non assume proprio nulla se non un mondo ignoto, lasciando spazio alla manipolazione algoritmica dei dati. Breiman, dopo anni di esperienza nella frenetica imprenditoria americana, optava per la seconda affidandosi all’accuratezza predittiva del machine learning: prima i risultati, poi i perché.

Questo, a motivo non solo della summenzionata multiplicity of good models, ma soprattutto del conflitto tra semplicità ed accuratezza: quale ipotesi scegliere, di fronte a molte? Il rasoio di Occam – entia non sunt multiplicanda praeter necessitatem – assume l’uniformità, affilando un’ipotesi fino a farla scollare dalla realtà. Viceversa, aumentando il numero di variabili (fino a svariati milioni) per interpretare un fenomeno, la filigrana si affina e la realtà diviene finalmente tangibile. Tuttavia, c’è la cosiddetta “maledizione della dimensionalità”: sopra un’imprecisata soglia, il numero di attributi rende l’ipotesi stessa incomprensibile. Ed ora che disponiamo di modelli potenti, ciò ci si ritorce contro. Siamo stati inghiottiti dalla complessità. I magici sistemi intelligenti sulla bocca di tutti – soprattutto i cosiddetti self-supervised quali i transformers GPT, che per certi versi definiscono da sé i propri criteri di apprendimento ¬– sono diventati insondabili proprio come la natura che dovevano modellare, e non possiamo dare la stessa risposta di Breiman. Abbiamo delle responsabilità sui rischi implicati da questi sistemi e proprio per questo gli algoritmi “osservatori” che servono per spiegarli – come LIME, SHAP, LORE ed altri – non devono essere complessi. Infatti, una spiegazione non è nient’altro che l’interpretazione di un sistema semplice che ne imita uno opaco.

E siamo punto e a capo: cos’è successo alla signora imbellettata? L’eXplainable AI, insomma, sembra soffrire un paradosso: mai troppo semplificando spiegazioni sempre parziali, dover usare rasoi smussati su macchine – come il personaggio di Pirandello – sempre col naso un po' storto.

Credits Copertina: Midjourney Bot

Leggi anche

L'energia dalle onde del mare: innovazioni e sfide per il futuro sostenibile del nostro pianeta

L'energia marina sta emergendo come una fonte rinnovabile cruciale. Innovazioni come i convertitori di energia d'onda negli Stati Uniti e in Italia, stanno rendendo possibile lo sfruttamento del moto ondoso. I principali progetti internazionali e i risultati dei test realizzati nella vasca navale dell'Università Federico II di Napoli, la più grande del mondo

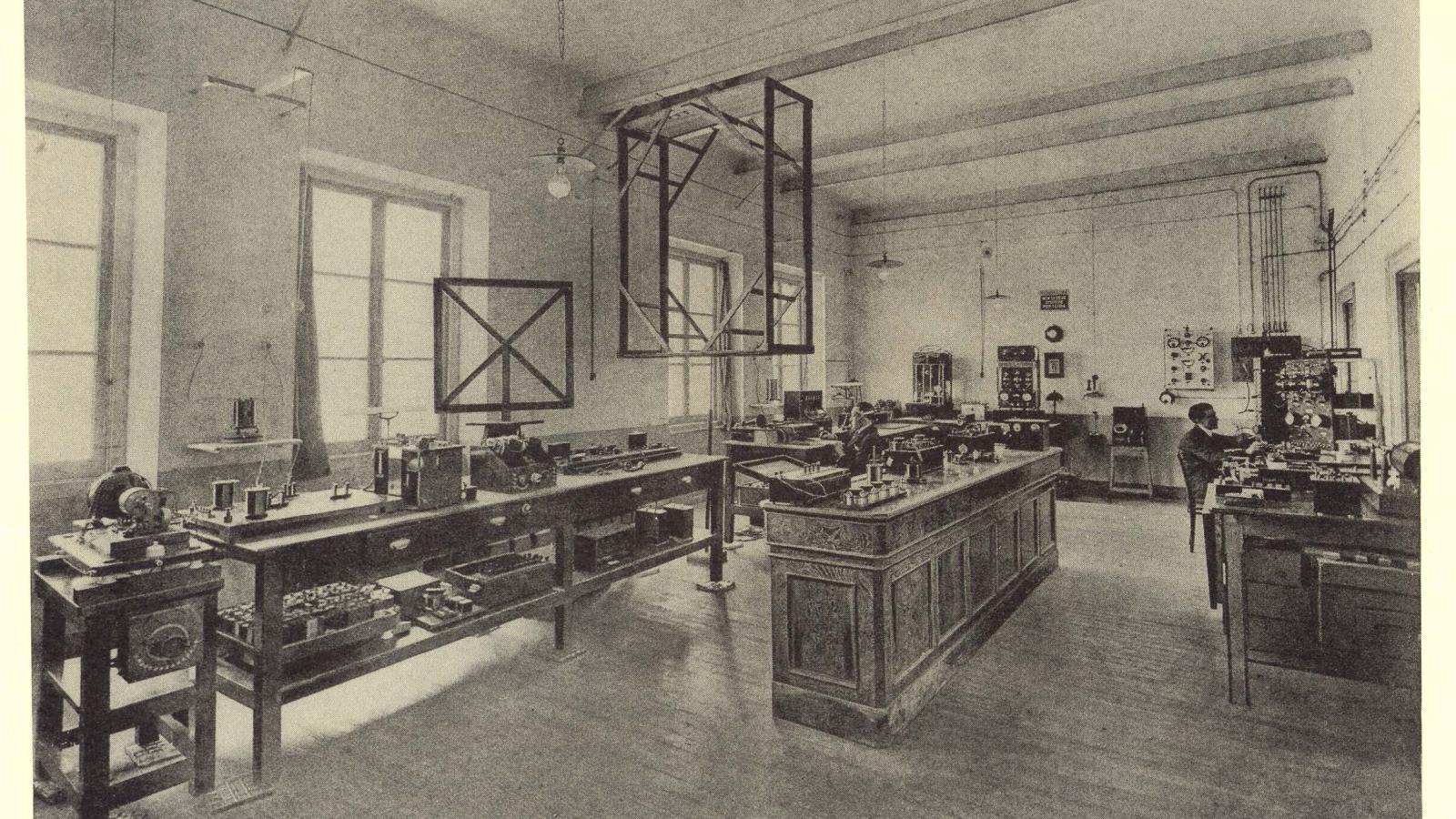

Il modello industriale di Marconi e il rapporto speciale con Genova

Evento al Salone Nautico di Genova, gli AD di Leonardo e Fincantieri si confrontano sull'eredità lasciata dall'inventore bolognese

Rigenerare il mare con le ostriche: il progetto di ENEA a La Spezia

Prototipi di barriere coralline con gli scarti della molluschicoltura per favorire il ripopolamento dell’ostrica piatta nel golfo della Spezia

Nanorobot e interfacce cerebrali: la rivoluzione del cervello connesso

Impiantare miliardi di nano-robot nel nostro cervello per dare agli esseri umani nuove e incredibili capacità