Il loop riaperto. Neuro-Symbolic AI

“Sonno dogmatico” fu l’altezzoso cigno che, sol per essere l’infinitesimo caso della specie, credette d’aver dimostrato la necessaria bianchezza del suo regale lignaggio. “Sonno dogmatico” è il modello neurale artificiale ritenuto, solo perché installato su di un comune computer, essere nulla più che una classica macchina di Turing.

Ma il risveglio – come fu quello confessato da Immanuel Kant nei Prolegomeni ad ogni futura metafisica del 1783, pieno di gratitudine verso David Hume – non è lontano. Vero è che il learning di una rete neurale è solo fittiziamente una generalizzazione induttiva: non fa salti e non inventa conclusioni da un indefinito numero di premesse. Piuttosto, modella i pesi di una funzione matematica già esistente ma flessibile, randomizzandoli dapprima e poi ciclicamente variandoli. Tuttavia – tralasciando le questioni di segreto industriale – l’esplosione di complessità computazionale dei sistemi intelligenti dell’ultima decade, soprattutto sub-simbolici, ha generato un enorme difetto di trasparenza. Spesso non è possibile constatare da quale input x derivi un certo output y, né ritrovare il filo che ha unito i due capi del labirinto.

Fonte: freepik.com

eXplainable Artificial Intelligence è l’indirizzo di ricerca mirato proprio a mitigare questo problema. Un tempo, da pioniere, Kant cercò di salvare lo statuto della conoscenza scientifica inventando i giudizi sintetici-a priori. I dati grezzi dell’esperienza dovevano convergere dentro architetture della mente – le strutture trascendentali – comuni a tutti gli umani, garanzia perciò di explainability. Oggi, per le medesime ragioni, l’informatica ne ripropone un calco: è la Neuro-Symbolic AI o NeSy, ibridazione di modelli logici e sub-simbolici, riflusso d’Illuminismo. Sollevare il coperchio della scatola nera, però, non equivale a riacquistare l’equilibrio perduto. Anzi, il loop è riaperto e l’utente, trascinatovi dentro, dovrà sapersi destreggiare. Un brillante esempio italiano viene da G. Pisano, G. Ciatto, R. Calegari e A. Omicini in Neuro-symbolic Computation for XAI: Towards a Unified Model, lavoro presentato al workshop From Objects to Agents all’Alma Mater di Bologna nel 2020. Un ragionatore automatico induttivo, primo modulo logico, traduce un network neurale già allenato in un complesso di relazioni intelligibili, del tipo di “se P, allora Q”. Queste, memorizzate, valgono come “teoria di riferimento”. I successivi cicli d’uso aggiornano la memoria estraendo altri gruppi di formule, detti “teorie esplicative”, e le discrepanze tra teorie sono gli errori. Un esperto umano, a quel punto – immaginiamo un oncologo che decida quanta importanza dare ai diversi dettagli di una TAC – formalizza le correzioni, le immette nuovamente in memoria, ed un secondo modulo logico – detto constraint – le trasforma in vettori numerici che regolarizzano i futuri apprendimenti del network. Sappia, insomma, che se dovesse presentarsi l’input tal dei tali, dovrà comportarsi proprio così.

Se però la logica, quanto a performance, potesse competere coi neuroni, la NeSy non esisterebbe. Ne è difatti un’imitatrice un po’ infedele. Una spiegazione dunque è un tratto in chiaroscuro, un parziale “non so”, perché tradurre è sempre tradire. Nemmeno l’esperto ha matematica certezza che il modello neurale “lo ascolti”: ha bisogno di sperimentare. Tuttavia, interpreta le divergenze tra le spiegazioni, addomestica l’errore e capovolge le limitazioni di prestazioni indotte dalla trasparenza in un pregio di accuratezza. Se un modulo logico traduce connessioni distribuite di numeri in un linguaggio formale perspicuo, comprensibile ad un essere umano e viceversa, e se questa traduzione conserva sempre la possibilità di fraintendere e correggersi, allora inizia un dialogo potenzialmente infinito. La corrispondenza circolare tra le parti interne del sistema fa il paio con il gioco tra il sistema stesso e l’utente finale, secondo il paradosso di una conoscenza che diviene più accurata proprio dove e perché è sfuggente.

Questa sarebbe la conseguenza etica più rilevante, e nessuno dei cinque principi etici riconosciuti in Intelligenza Artificiale – autonomia, giustizia, beneficenza, non maleficenza, esplicabilità – ne potrebbe cogliere la portata, perché tarato ancora su un concetto fortemente strumentale dei sistemi intelligenti.

Leggi anche

L'energia dalle onde del mare: innovazioni e sfide per il futuro sostenibile del nostro pianeta

L'energia marina sta emergendo come una fonte rinnovabile cruciale. Innovazioni come i convertitori di energia d'onda negli Stati Uniti e in Italia, stanno rendendo possibile lo sfruttamento del moto ondoso. I principali progetti internazionali e i risultati dei test realizzati nella vasca navale dell'Università Federico II di Napoli, la più grande del mondo

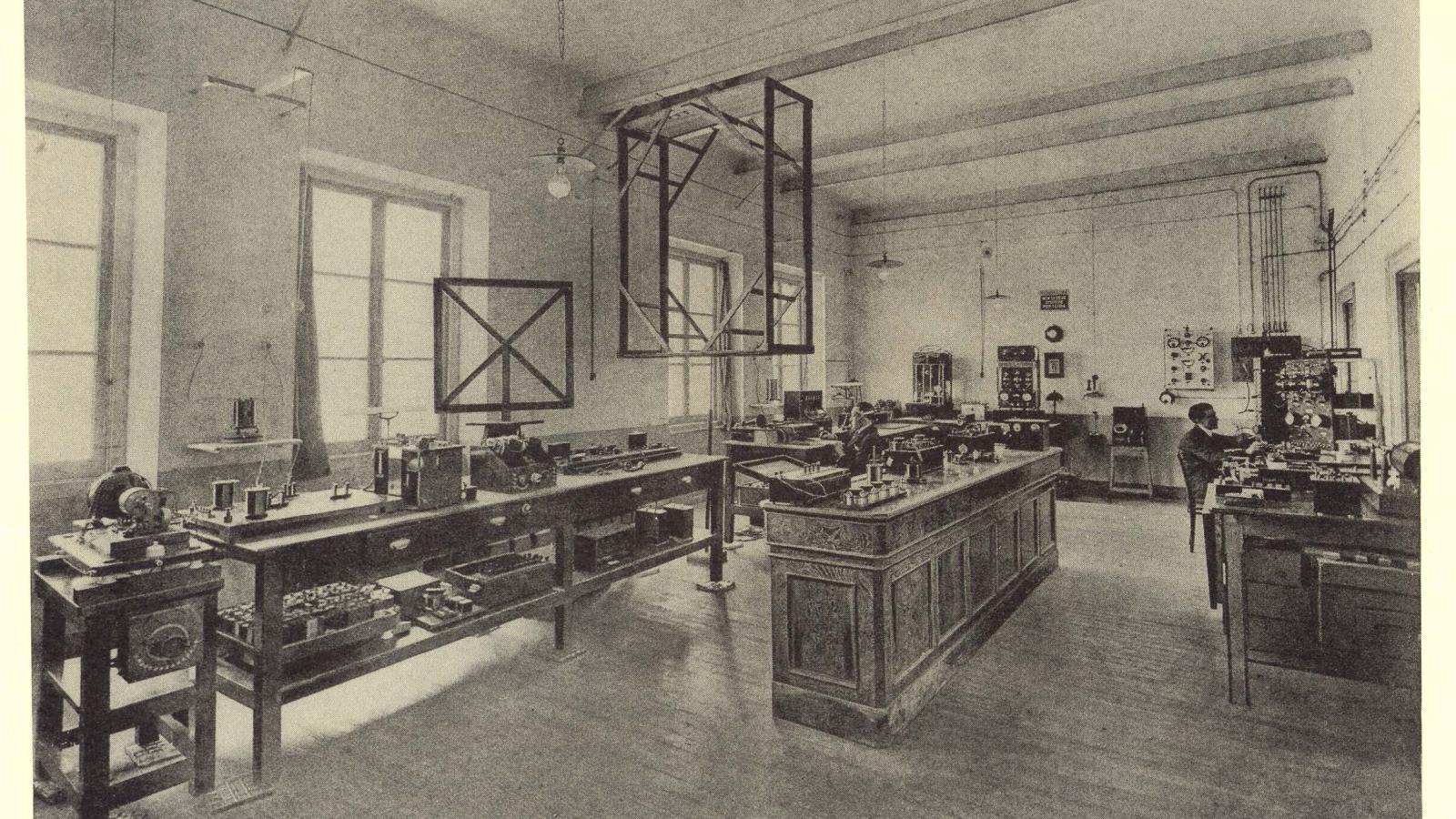

Il modello industriale di Marconi e il rapporto speciale con Genova

Evento al Salone Nautico di Genova, gli AD di Leonardo e Fincantieri si confrontano sull'eredità lasciata dall'inventore bolognese

Rigenerare il mare con le ostriche: il progetto di ENEA a La Spezia

Prototipi di barriere coralline con gli scarti della molluschicoltura per favorire il ripopolamento dell’ostrica piatta nel golfo della Spezia

Nanorobot e interfacce cerebrali: la rivoluzione del cervello connesso

Impiantare miliardi di nano-robot nel nostro cervello per dare agli esseri umani nuove e incredibili capacità