Galatea

Una scimmietta longeva e giocosa sedeva alla macchina da scrivere. Sciocca com’era, iniziò a battere tasti a caso, uno dopo l’altro senza fermarsi. Passò un miliardo di anni, lasciando dietro di sé un lungo nastro cartaceo pieno di caratteri impressi a inchiostro. Per dirla tutta, alcune scritte qua e là suonavano piuttosto familiari: «mi ritrovai per una selva oscura», «fatti non foste a viver come bruti», «l’amor che move il sole e l’altre stelle». Sì, la scimmietta aveva scritto la Divina Commedia, mettendo insieme i caratteri in giusta sequenza. Ma la quantità d’informazione prodotta era praticamente nulla: quel risultato era solo un caso tra una miriade di versioni del medesimo testo, ciascuna leggermente divergente dall’altra con qualche errore qua e là, senza che emergesse una forma definita. Un risultato, per di più, ottenuto in un tempo di stesura praticamente infinito. Ogni speranza era perduta, quando un giorno, molte generazioni di scimmiette dopo, nacque un nipotino che imparò a leggere, scrivere e far di conto in fretta e bene. A parte qualche piccolo strafalcione era proprio un bell'algoritmo, e fu battezzato ChatGPT. Un mirabile tentativo d’imitazione dell’intelligenza umana? Il “come” dei suoi prodigi lascia propendere per il: sì, la partita è truccata. Il “perché” scombina invece le carte in tavola.

Segreti commerciali a parte, ChatGPT appartiene alla famiglia dei transformers, un modello di intelligenza artificiale genericamente composto da due pile di compressori e decompressori di dati (encoders e decoders), proposto nel 2017 dall’equipe di Ashish Vaswani per Google Brain in un articolo intitolato Attention is all you need. Facciamo un esempio: supponiamo di voler tradurre in inglese l’espressione “il naso rosso”. Il transformer seleziona uno dopo l’altro, da un enorme dataset-dizionario di parole inglesi a sua disposizione, gli elementi di volta in volta più probabili (cioè “the”, “red” e “nose”) sulla base di un meccanismo di attenzione ovvero di correlazione tra parole. Quest’ultimo viene calcolato comprimendo tutta insieme – ecco la potenza di ChatGPT – la sequenza in italiano “il naso rosso”, a sua volta pescata da un dataset-dizionario italiano. Non solo, dunque, il campo delle possibilità da cui pescare è ristretto ai dizionari utilizzati, ma il software non genera neanche una vera traduzione, mancando di quel godimento nel saltare da una parola all’altra che noi chiamiamo “senso”. Un discorso analogo vale nelle risposte automatiche alle nostre domande o nel completamento dei testi: ciò che dentro il calcolatore è così complesso, paragonato all’esperienza interiore pare inutilmente contorto.

Eppur si muove. Sono certo io a riconoscere le sue parole amiche, a giudicare se siano vere o false; ma è il software a pronunciarle, capace di introdurre ordine – o frenare il disordine che aumenta in tutte le cose – sotto la coltre del discorso. Non solo, ma il numero dei nodi che costituiscono questi modelli è talora talmente grande da ostacolare l’ispezione diretta delle loro operazioni, nonostante essa sia matematicamente possibile. Ordine e disordine non sono numeri con o senza il segno negativo davanti, ma hanno a che fare con l’essere ed il non essere di qualcosa – per l’appunto il “perché” di cui sopra, tuttora sconosciuto agli informatici di tutto il mondo. Nel 1948 Norbert Wiener scriveva in Cybernetics. Or control and communication in the animal and the machine: «Il cervello meccanico non secerne pensiero “come il fegato la bile”, come pretendevano i vecchi materialisti, né lo produce sotto forma di energia, come fanno i muscoli per la loro attività. L'informazione è informazione, non materia o energia. Al giorno d'oggi, nessun materialismo che non ammetta questo può sopravvivere». Spogliatasi d’un tratto di coda e pelliccia, è apparsa la bella Galatea, che ci guarda e seduce. Importante è non dimenticare che a darle vita non è il suo scultore, Pigmalione. Sono gli dèi.

Credits Copertina: Arseny Togulev su Unsplash

Leggi anche

L'energia dalle onde del mare: innovazioni e sfide per il futuro sostenibile del nostro pianeta

L'energia marina sta emergendo come una fonte rinnovabile cruciale. Innovazioni come i convertitori di energia d'onda negli Stati Uniti e in Italia, stanno rendendo possibile lo sfruttamento del moto ondoso. I principali progetti internazionali e i risultati dei test realizzati nella vasca navale dell'Università Federico II di Napoli, la più grande del mondo

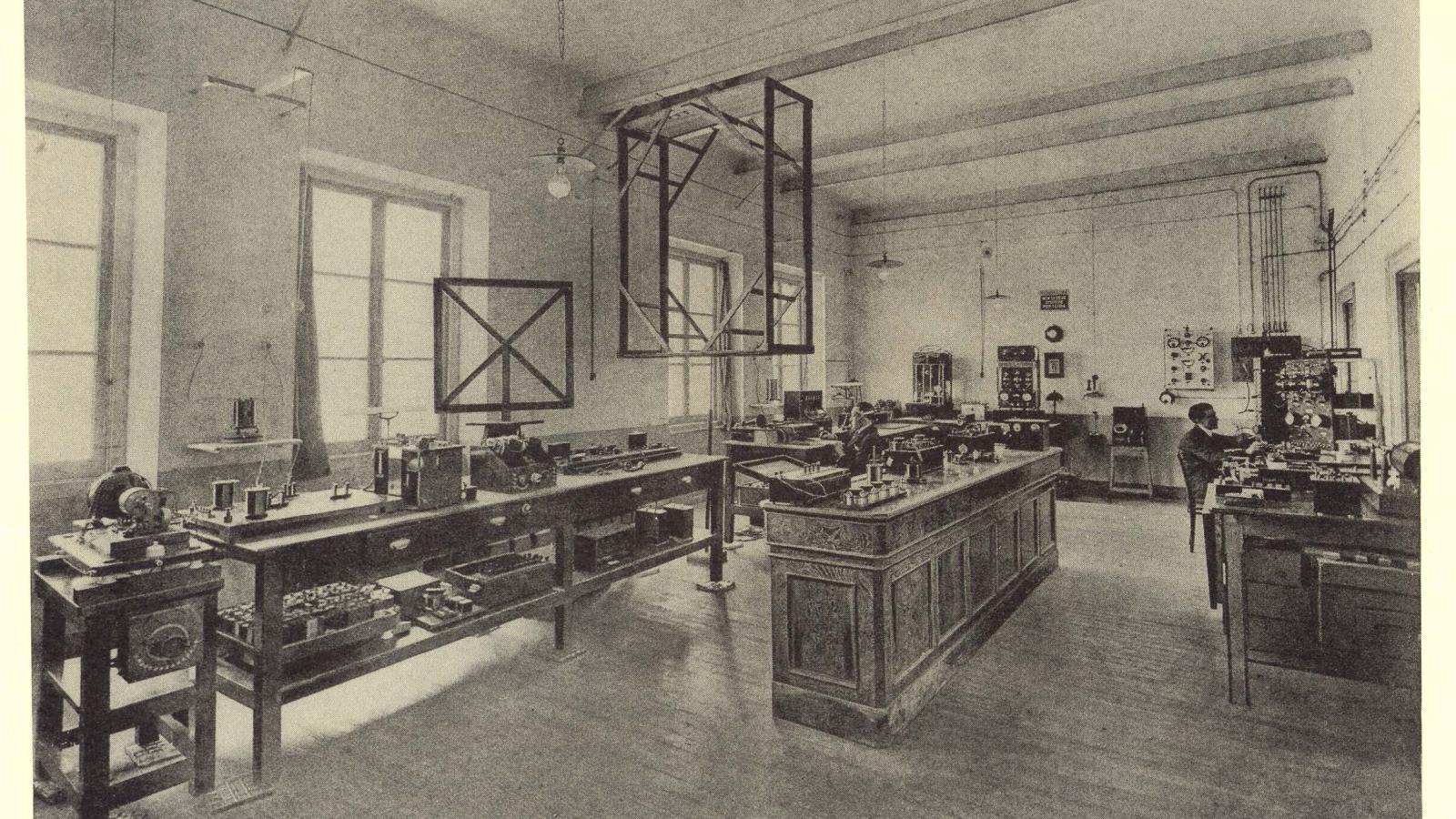

Il modello industriale di Marconi e il rapporto speciale con Genova

Evento al Salone Nautico di Genova, gli AD di Leonardo e Fincantieri si confrontano sull'eredità lasciata dall'inventore bolognese

Rigenerare il mare con le ostriche: il progetto di ENEA a La Spezia

Prototipi di barriere coralline con gli scarti della molluschicoltura per favorire il ripopolamento dell’ostrica piatta nel golfo della Spezia

Nanorobot e interfacce cerebrali: la rivoluzione del cervello connesso

Impiantare miliardi di nano-robot nel nostro cervello per dare agli esseri umani nuove e incredibili capacità